La tecnologia sviluppata consente di comandare da remoto una macchina automatica o un robot tramite una analisi visiva delle posture assunte da un operatore. Sono stati sviluppati due casi d'uso per sperimentare la tecnologia: • in un primo caso il sistema riconosce alcune posture dell'utente a cui corrispondono movimenti programmati, • nel secondo caso il sistema viene comandato ad eseguire un movimento elementare che viene registrato come punto di passaggio per la costruzione di configurazioni complesse, sempre in base al riconoscimento di una posa.

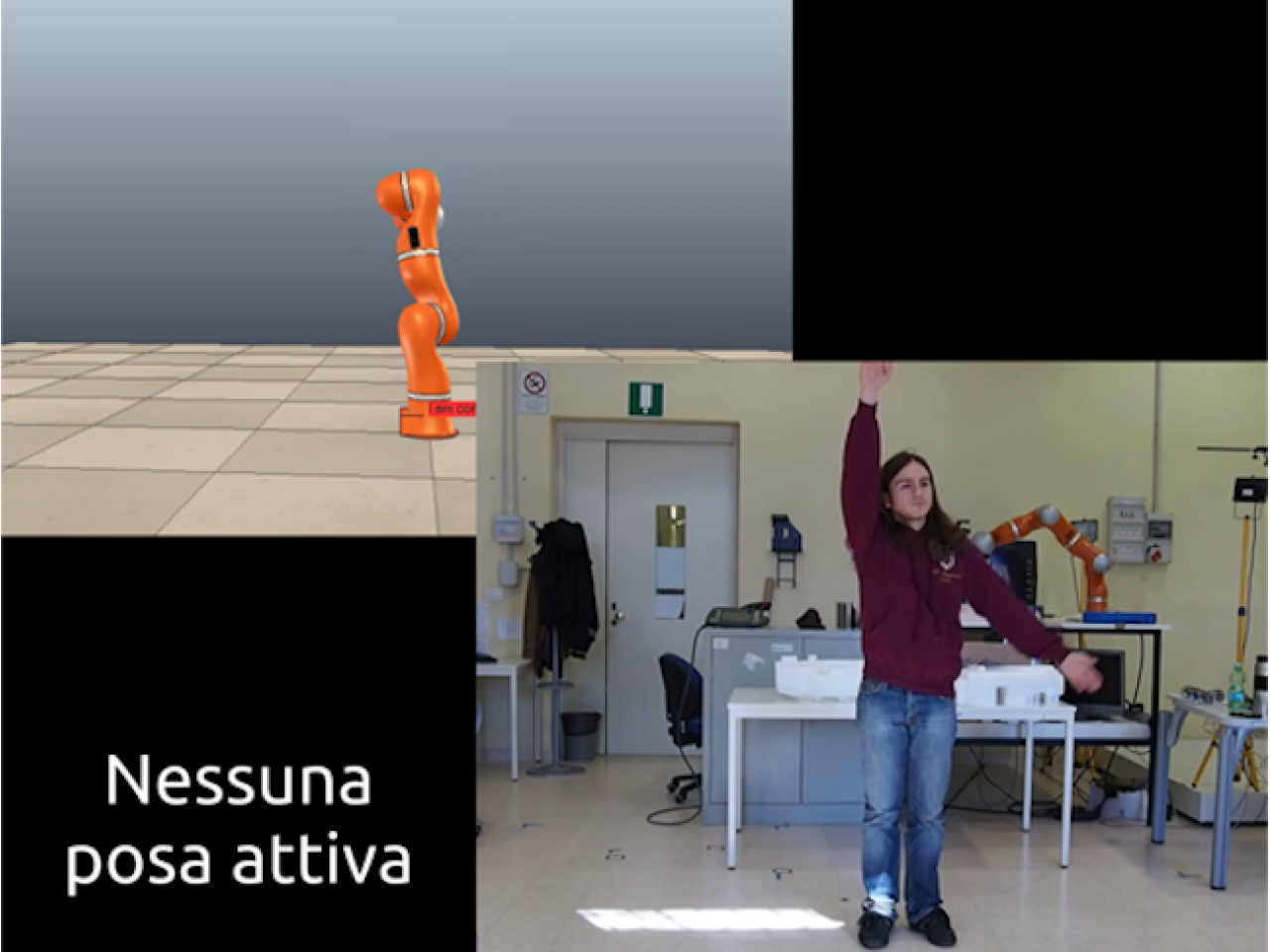

Simulatore del sistema di controllo del robot

Simulatore del sistema di controllo del robot

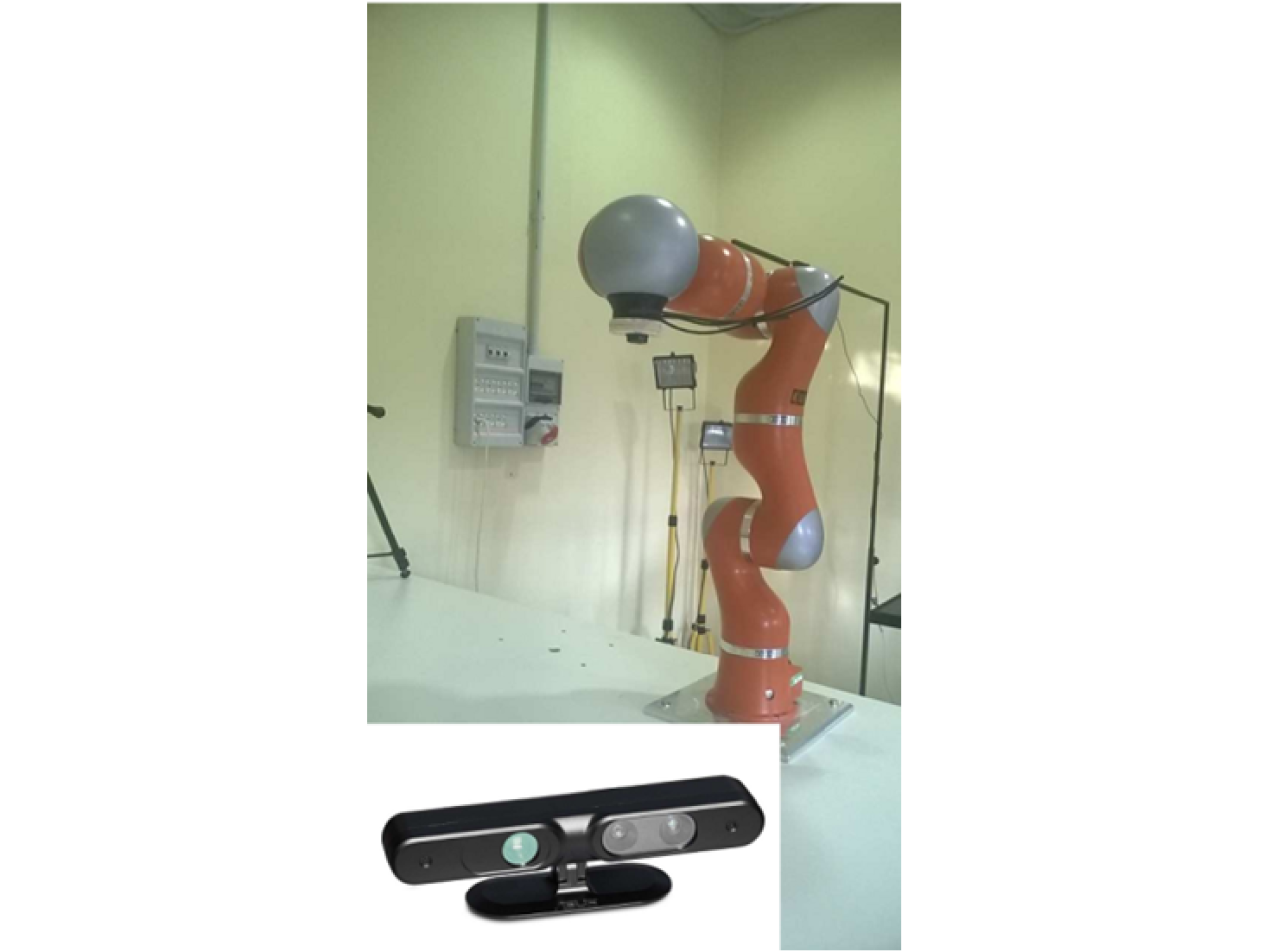

Il prodotto è costituito da una telecamera Xtion PRO di ASUS per l'acquisizione di pose dinamiche "motion-sensing", e da un software che interpreta e riconosce le pose assunte da un operatore umano inquadrato dalla telecamera. Il sistema è in grado di riconoscere le pose di un operatore umano e di elaborare dei comandi da impartire ad un sistema automatico, sia esso un robot manipolatore o una macchina automatica. I comandi da impartire possono essere programmati in precedenza (modalità di comando), per cui il sistema riconosce una posa e la associa ad una serie di movimenti o azioni comunque complessi. Nella secondo modalità di utilizzo i comandi vengono riconosciuti come una richiesta di spostamento del robot asservito, che possono poi venire registrati in sequenza (modalità remote-teach pendant).

Il sistema abilita un comando remoto di una macchina o robot tramite gesti eseguiti con le braccia, e quindi costituisce una modalità innovativa di interazione tra la macchina e l'operatore umano senza contatto. Il sistema è innovativo rispetto alle comuni modalità di interazione, come ad esempio i pannelli operatore che per poter essere utilizzati necessitano di una vicinanza e un contatto fisico tra l'operatore e la macchina.

Il sistema può essere utilizzato per operare a distanza con macchine automatiche e robot. Ad esempio un operatore può comandare a distanza l'avvio di una macchina o il suo fermo con un gesto della mano, trovandosi in un punto di osservazione di un difetto. Una seconda applicazione è l'apprendimento delle traiettorie di lavoro di un robot tramite una guida analoga alla modalità tradizionale "teach-pendant" però senza limitare la posizione dell'operatore.

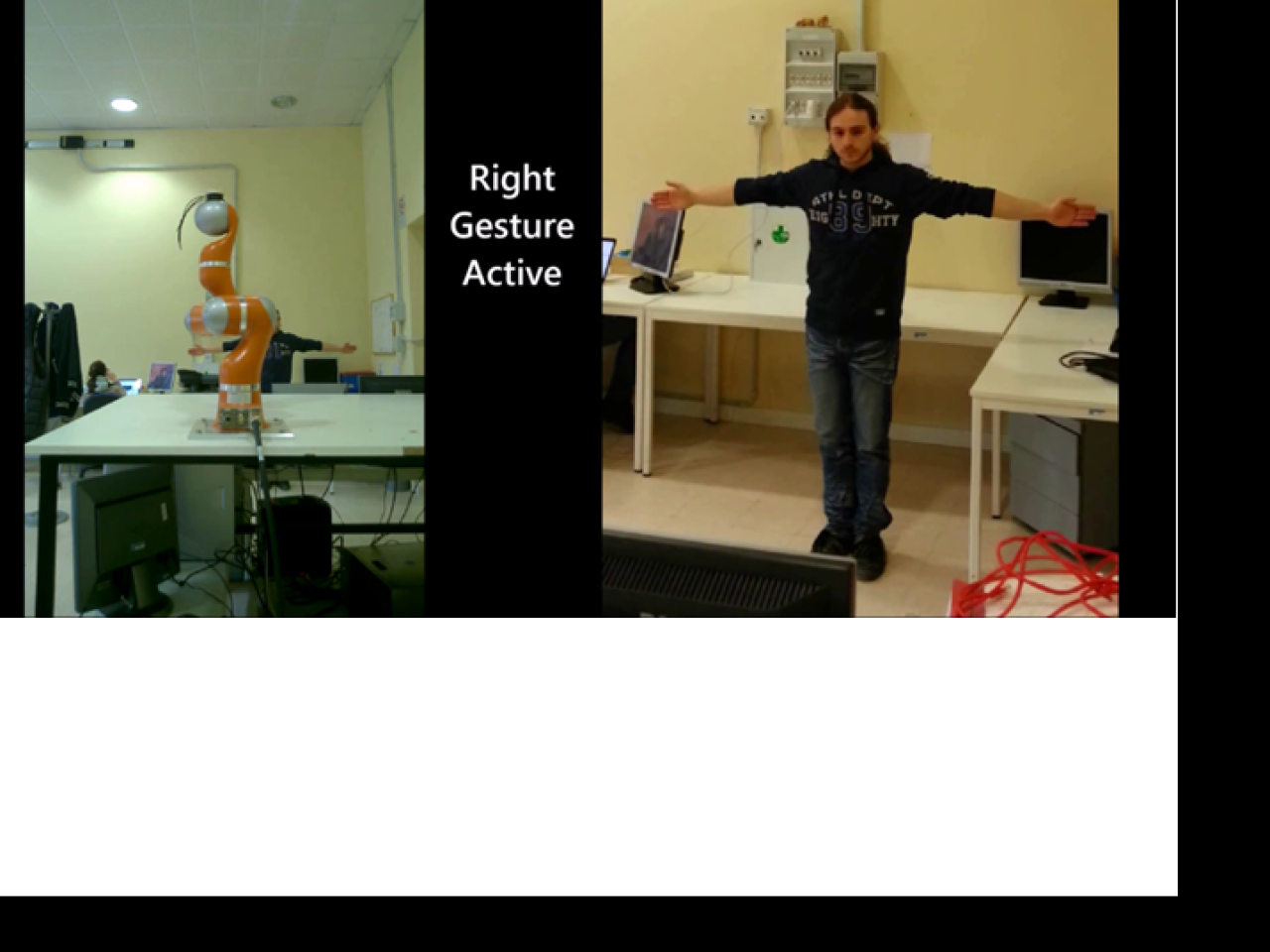

Sistema di controllo del robot

Sistema di controllo del robot

Controllo remoto di robot industriali

Il laboratorio ha sviluppato una applicazione di HMI (Human-Machine Interface) basato su una Natural Interface, in particolare sulla «Gesture Recognition» di particolari pose statiche denominate "Static Gestures". L'ambiente software su cui è stata elaborata questa interfaccia è ROS (Robotic Operating System), lo standard open source per la programmazione e controllo di sistemi robotici. Le «Static Gestures» vengono rilevate mediante l'utilizzo di un dispositivo motion sensing, l'Asus Xtion Pro Live, tracciate mediante un software package dedicato e riconosciute attraverso un programma basato su un algoritmo di riconoscimento appositamente progettato. L’interfaccia naturale, caratterizzata da una totale invisibilità, consente nella applicazione di comandare un braccio robotico a 7 gradi di libertà KUKA LWR 4+. Un software di interfaccia si occupa della generazione delle traiettorie utilizzate per il controllo in posizione del robot, acquisite mediante la identificazione di semplici pose gestuali assunte dall’operatore. Il sistema è dotato di un simulatore V-REP, per la validazione off-line della applicazione in ambiente virtuale. Il sistema è stato in grado di funzionare senza errori di riconoscimento di pose per 10 ore consecutive di funzionamento. L'operatore che ha condotto i test ha mostrato di percepire una condizione lavorativa confortevole e rilassante.

Azienda del settore della progettazione e costruzione di macchine per la lavorazione del legno.

Il laboratorio è in cerca di imprese che vogliano valorizzare questa applicazione nei loro scenari produttivi e applicativi. L'impresa partner ideale ha caratteristiche di spiccata innovazione e produce robot o macchine automatiche con una interazione intensiva con l'operatore umano.

Braccio robotico e Kinect

Braccio robotico e Kinect